Tomografia komputerowa, TK, CT (od ang. computed tomography) – rodzaj tomografii rentgenowskiej, metoda diagnostyczna pozwalająca na uzyskanie obrazów tomograficznych (przekrojów) badanego obiektu. Wykorzystuje ona złożenie projekcji obiektu wykonanych z różnych kierunków do utworzenia obrazów przekrojowych (2D) i przestrzennych (3D). Urządzenie do TK nazywamy tomografem, a uzyskany obraz tomogramem. Tomografia komputerowa jest szeroko wykorzystywana w medycynie i technice.

Geneza

Podstawą przy powstawaniu tomografii można uznać prace doktora medycyny Karola Mayera, który w lutym 1914 na spotkaniu Krakowskiego Towarzystwa Lekarskiego omówił możliwość uzyskania "czystego" obrazu serca. Można było tego dokonać przez wprawienie w ruch lampy rentgenowskiej (dotąd statycznej) podczas badania co ograniczało uwidocznienie się cieni pochodzących od innych narządów. Swoje prace opublikował w niewielkim nakładzie i tylko w języku polskim w czasie toczącej się wojny co spowodowało niewielkie zainteresowanie. Publikacje te zostały wykorzystane w przewodzie habilitacyjnym 1917 przez prof. Walerego Jaworskiego i prof. Mariana Smoluchowskiego. W 1916 francuski dermatolog André Bocage rozpoczął rozważania nad możliwością zastosowania ruchomej lampy oraz ruchomej kasety z kliszą według ściśle określonych wzorców geometrycznych. Opatentował to w 1921. Pomysł ten pozostawał w sferze teorii i hipotez. W 1930 włoski badacz Alessandro Vallebona skonstruował prototyp aparatu, który pozwalał na wydobywanie poszczególnych warstw w obrazowaniu radiologicznym dzięki krążącym w przeciwnych kierunkach wokół ciała człowieka lampie i kliszy. W 1934 niemiecki konstruktor i producent Gustav Grossmann opatentował aparat, który wszedł do seryjnej produkcji. Producent firma Sanitas Berlin GmbH przyjęła zaproponowaną przez Grossmanna nazwę tomograf[1]. Pierwszy tomograf komputerowy, tzw. EMI scanner, został zbudowany w 1967 przez Godfreya Hounsfielda, z brytyjskiej firmy EMI Ltd. Zastosowane zostały dostępne wówczas komputery do skomplikowanych obliczeń. Był to moment przejścia z tomografii rentgenowskiej do tomografii komputerowej. Podstawy matematyczne tego wynalazku są zasługą austriackiego matematyka Johanna Radona. W 1917 udowodnił on, że obraz dwu- i trójwymiarowego obiektu można odtworzyć w sposób zupełny z nieskończonej liczby rzutów tego przedmiotu. W 1956 Ronald Bracewell użył tej metody do stworzenia map słonecznych. Także polski uczony Stefan Kaczmarz w 1937 zaprezentował oryginalny sposób rozwiązywania równań liniowych tzw. metoda Kaczmarza, która stanowiła wraz z teoretycznymi założeniami Alana Turinga podstawę współczesnych technik TK. Pierwsze urządzenia próbujące wykorzystać idee Radona budowali: w 1961 William Henry Oldendorf, w 1963 Allan MacLeod Cormack (Tufts University), w 1968 David Kuhl i Roy Edwards. Wszyscy oni przyczynili się do końcowego efektu osiągniętego przez Hounsfielda, który jako pierwszy stworzył działający system do diagnostyki i zaprezentował jego unikatowe możliwości w 1967 a opatentowane rok później[1].

Hounsfield i Cormack otrzymali w 1979 Nagrodę Nobla za wynalezienie i budowę tomografu komputerowego[2].

Pierwszy tomograf zainstalowano w szpitalu Atkinson Morley Hospital, w londyńskim Wimbledonie. Pierwszy pacjent został tam przebadany w 1971[2]. W Stanach Zjednoczonych sprzedawano go w cenie 390 000 USD, a pierwszy zamontowano w 1973 w Mayo Clinic i Massachusetts General Hospital.

EMI scanner – pierwszy tomograf komputerowy

Pierwszy działający tomograf przeznaczony był wyłącznie do prześwietleń mózgu. Głowę pacjenta otaczała woda. Była ona potrzebna do ograniczenia ilości promieniowania docierającego do detektorów. Urządzenie składało się z obrotowego statywu utrzymującego lampę rentgenowską po jednej stronie, a po przeciwnej dwa detektory rejestrujące. Poniżej lampy znajdował się trzeci detektor pomocniczy, monitorujący działanie lampy rentgenowskiej. Lampa wykonywała ruch złożony – translacyjno-obrotowy. Obracała się wraz z detektorami dookoła głowy pacjenta w zakresie 0° do 179°, co jeden stopień. Oś obrotu przechodziła przez środek głowy pacjenta. W każdej pozycji statywu, lampa wykonywała dodatkowo ciągły ruch liniowy na całej szerokości głowy. Wtedy właśnie dokonywano 160 naświetleń promieniami X, a detektory odbierały niepochłonięte przez ciało pacjenta promieniowanie. Łącznie zbierano więc 28 800 projekcji głowy w dwóch warstwach (dwa detektory). Pojedyncze prześwietlenie trwało 4–5 minut. Typowe badanie, ok. 25 minut. Zdjęcia były rekonstruowane przez minikomputer Data General Nova. Obróbka jednego zdjęcia zajmowała ok. 7 minut (prototypowi zajmowało to 2,5 godziny). Uzyskany obraz miał rozdzielczość 80 na 80 pikseli i obejmował stały obszar 27 na 16 centymetrów.

Pierwszym tomografem komputerowym mogącym badać dowolną część ciała i nie wymagającym zbiornika wodnego, był ACTA scanner (ACTA Model 0100 CT Scanner), zaprojektowany w 1973 przez stomatologa i biofizyka Roberta Ledleya z Uniwersytetu Georgetown. Obecnie ACTA scanner znajduje się w National Museum of American History.

Rekonstrukcja obrazu

Ogólna zasada tworzenia obrazu tomograficznego

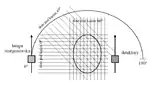

Źródło promieniowania i detektory poruszają się po okręgu prostopadłym do długiej osi pacjenta (dookoła obrazowanego narządu/obiektu), wykonując szereg prześwietleń wiązką promieniowania równoległą do płaszczyzny obrazowanej. Strumień danych z detektorów zawiera informacje na temat pochłaniania promieniowania przez poszczególne tkanki (elementy składowe obiektu). Dane zostają zapisane na twardym dysku komputera. Informacje z uzyskanych prześwietleń są poddawane obróbce komputerowej w celu uzyskania czytelnego obrazu. Za pomocą skomplikowanej analizy, uwzględniającej ile promieniowania zostało pochłonięte przy napromieniowaniu obiektu z danej strony, tworzone są obrazy przedstawiające kolejne przekroje badanego narządu. Obrazy są monochromatyczne (czarno-białe). Możliwa jest również obróbka komputerowa pozwalająca na przestrzenną rekonstrukcję poszczególnych narządów. Każdy przekrój przez obiekt jest dzielony na małe części, woksele, reprezentujące fragment obrazowanej objętości. Do każdego woksela przypisywana jest liczbowa wartość proporcjonalna do stopnia, w którym pochłania on promieniowanie. Aby w danej warstwie określić tę wartość dla n fragmentów, potrzebne jest przynajmniej n równań opisujących pochłanianie w danej warstwie. Trzeba więc posiadać n różnych projekcji tej warstwy. Im więcej mamy projekcji, tym lepszą dokładność obrazu uzyskamy. EMI scanner wykonywał obrazy o rozdzielczości 80 × 80 pikseli (6400 równań) z 28 800 projekcji. Współczesne tomografy wykonują nawet do 2 000 000 projekcji. Dzięki temu ich rozdzielczość sięga dziesiątek mikrometrów. Z powodu ilości równań wymaganych do odtworzenia obrazu, nie można było zrealizować tomografii w chwili jej wynalezienia, w 1917. Dopiero pojawienie się komputerów z ich możliwościami obliczeniowymi utorowało drogę do praktycznego wykorzystania tomografii.

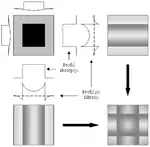

Metoda sumacyjna – „back projection”

Metoda sumacyjna jest najstarszą i zarazem najprostszą metodą odtworzenia obrazu. Łatwo na niej przedstawić proces odtwarzania obrazu mimo że nie jest ona stosowana w praktyce. Ideę metody sumacyjnej przedstawiono na rysunku obok. Obiekt jest prześwietlany (A) z dwóch stron: podłużnie, B1, i poprzecznie, B2. Gdy zsumujemy obie projekcje (numerycznie lub sumując zaciemnienie), otrzymamy obraz niezbyt dokładny, ale pozwalający wnioskować o wewnętrznej budowie obrazowanego obiektu (C). Można też sobie wyobrazić, że dodanie kolejnych projekcji (np. „z ukosa”) spowoduje polepszenie wierności odtworzonego obrazu.

Metody iteracyjne

Metody iteracyjne polegają na znalezieniu współczynnika pochłaniania poszczególnych wokselach poprzez kolejne próby modyfikacji tych współczynników tak, aby ich wartości zgadzały się ze zmierzonymi. Proces rekonstrukcji rozpoczyna się od przyjęcia założeń początkowych dotyczących współczynników pochłaniania w wokselach – na przykład że wszystkie są sobie równe. Następnie porównuje się je z wielkościami zmierzonymi i dokonuje modyfikacji. Kolejne porównania i modyfikacje (iteracje) kontynuuje się aż do uzyskania zgodności między wartościami pochłaniania zmierzonymi a wyznaczonymi. Metoda iteracyjna występuje w trzech odmianach:

- rekonstrukcja jednoczesna – obliczenia prowadzi się dla wszystkich projekcji i na całej matrycy wokseli. Wszystkie poprawki w danej iteracji również wprowadzane są jednocześnie.

- korekcja promień po promieniu – cykle iteracyjne obliczeń i poprawek są prowadzone po kolei dla każdej projekcji. Tego rodzaju metodę rekonstrukcji użyto w EMI scanner (patrz rysunek po lewej). Zwykle potrzeba od 6 do 12 iteracji, aby uzyskać zadowalającą dokładność.

- korekcja punkt po punkcie – obliczenia prowadzi się dla każdego woksela po kolei, z uwzględnieniem wszystkich projekcji, w których promienie przechodziło przez dany woksel.

Metody analityczne

Metody analityczne są używane w niemal wszystkich współczesnych tomografach. Dają one najlepsze wyniki, ale wymagają większych mocy obliczeniowych. Najpopularniejszymi z nich są:

- dwuwymiarowa analiza Fourierowska – wykorzystuje ona transformatę Fouriera do opisania otrzymanych profili pochłaniania. Transformacie poddaje się każdą z projekcji i dzięki temu uzyskuje się współczynniki pochłaniania w każdym z wokseli.

- metoda sumacyjna z filtrowaniem – podobna do zwykłej metody sumacyjnej z tym, że obraz jest filtrowany (modyfikowany) w celu przeciwdziałania efektom powodowanym przez nagłe zmiany gęstości w badanym obiekcie, a które pogarszają jakość obrazu w metodzie sumacyjnej (patrz rysunek z prawej).

Liczby CT – jednostki Hounsfielda

Jak napisano wyżej, z zebranych danych komputer tomografu oblicza współczynniki pochłaniania dla każdego z pikseli tworzących obraz. Gdy zostaną już wyznaczone, ich wartości zostają przeliczone na tak zwane liczby CT (CT numbers), nazywane czasem jednostkami Hounsfielda (HU, Hounsfield units). Konwersja ta pozwala na przedstawienie obrazu w odcieniach skali szarości. Przeliczenie polega na odniesieniu wyznaczonego współczynnika pochłaniania do jego wartości dla wody:

gdzie: K – stała wzmocnienia obrazu, indywidualna dla tomografu; – wyznaczony współczynnik pochłaniania piksela; – wyznaczony współczynnik pochłaniania wody (wartość odniesienia). Stała K pierwszego tomografu, EMI scanner, wynosiła 500, a zakres rejestrowanych liczb CT wynosił od −500 (dla powietrza) do +500 (dla gęstych kości). Współczesne tomografy mają stałą K większą od 1000, a zakres liczb CT jest szerszy od −1000 do +4000.

Generacje tomografów

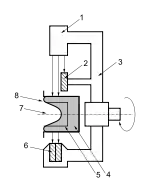

- Pierwsza generacja: tomografy te używały cienkiej wiązki równoległej skierowanej na jeden lub dwa detektory. Obraz uzyskiwano poprzez ruch translacyjno-obrotowy lampy rentgenowskiej i detektora. Te zaś były nieruchome względem siebie. Po każdym obrocie lampa i detektory wykonywały ruch translacyjny i dokonywały serii naświetlań wzdłuż badanego obiektu (patrz rysunek). Detektorami były scyntylatory z jodkiem sodu połączone z fotopowielaczem.

- Druga generacja: Wzrosła liczba detektorów a kształt wiązki zmieniono na wachlarzowaty. Pozostawiono ruch translacyjno-obrotowy. Czas potrzebny na wykonanie badania znacząco uległ skróceniu dzięki zwiększeniu kąta pojedynczego obrotu lampy/detektora do 30° oraz wielu detektorów. Czas pojedynczego skanu wynosił od 10 do 90 sekund.

- Trzecia generacja: była przełomem dla techniki tomografii komputerowej (1975, przez firmę General Electric). Wachlarzowata wiązka promieniowania skierowana była na zestaw detektorów (obecnie, ponad 700) nieruchomych względem lampy rentgenowskiej. Wyeliminowanie ruchu translacyjnego pozwoliło na skrócenie czasu skanowania do 10 sekund (obecnie, nawet poniżej 1 sekundy). Pociągnęło to za sobą wzrost praktyczności TK. Czas badania stał się na tyle krótki, że umożliwił zobrazowanie płuc i jamy brzusznej; poprzednie generacje ograniczały się do głowy i kończyn.

- Czwarta generacja: przedstawiono ją niemal równolegle z trzecią generacją. Daje podobne rezultaty, co 3. generacja. Zamiast rzędu detektorów poruszających się w ślad za lampą, zastosowano tu pierścień detektorów (składający się z ponad nawet 2000 detektorów, np. w tomografach firmy Picker PQ5000 jest 4800 detektorów). Ruchoma jest tylko lampa rentgenowska.

Inne odmiany tomografii komputerowej

Tomografia komputerowa występuje czasem pod innymi terminami, które próbują podkreślić charakterystyczną cechę jej odmiany. Na przykład:

- CAT (computerized axial tomography) – komputerowa tomografia osiowa – tomografia, w której oprócz ruchu lampy rentgenowskiej występuje również podłużny (osiowy) ruch łoża z pacjentem. Dzięki temu, lampa w każdym momencie prześwietla kolejny fragment, warstwę, ciała pacjenta

- HRCT (high-resolution computed tomography) – tomografia komputerowa wysokiej rozdzielczości (TKWR) – nazwa używana w odniesieniu do tomografów o bardzo wysokiej rozdzielczości rekonstruowanego obrazu

- MSCT (multi-slice computed tomography) lub MDCT (multi-row detector computed tomography) – wielorzędowa tomografia komputerowa

Istnieją też inne, niż rentgenowska, odmiany tomografii. Różnią się one rodzajem zastosowanego promieniowania i techniki tomograficznej. Jednym z przykładów jest młoda i rozwijająca się technika, zwana pozytonową tomografią emisyjną (PET). W metodzie tej, zamiast prześwietlania, podaje się pacjentowi preparat zawierający krótko żyjące izotopy promieniotwórcze rozpadające się z emisją pozytonów, ich anihilacja wywołuje promieniowanie gamma, które jest rejestrowane. Na tej podstawie można obserwować metabolizm podanego pierwiastka. Metoda ta służy między innymi do wykrywania nowotworów. Z technik tomograficznych korzystają również urządzenia do badania rezonansem magnetycznym (RM).

Zastosowanie w diagnostyce

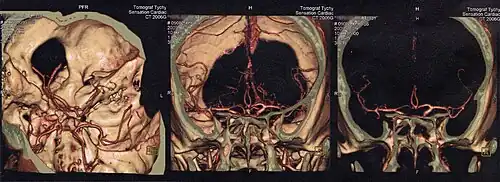

Głowa

Tomografia komputerowa jest obecnie podstawowym badaniem obrazowym pozwalającym na uwidocznienie struktur śródczaszkowych. Powinna być wykonana jak najszybciej w przypadku udaru mózgu w celu zróżnicowania pomiędzy udarem niedokrwiennym i krwotocznym. Pozwala też wykryć obecność guza śródczaszkowego albo krwiaka pourazowego.

Bezpieczeństwo tomografii komputerowej

Zagrożenia

Rentgenowska tomografia komputerowa wykorzystuje promieniowanie rentgenowskie do wykonywania przekrojowych zdjęć obiektów. Promieniowanie to jest promieniowaniem jonizującym, co wiąże się z potencjalnym zagrożeniem dla życia i zdrowia organizmów żywych w wypadku nadmiernej ekspozycji. W niewielkim, ale zauważalnym stopniu wzrasta ryzyko wystąpienia nowotworu. Ponadto niektórzy pacjenci uczuleni są na środki cieniujące, które zwykle zawierają związki jodu. Innym mogą one uszkodzić nerki. Jeśli środek kontrastowy otrzyma kobieta karmiąca piersią, to przed wznowieniem karmienia musi odczekać przynajmniej 24 godziny. Badanie TK napromieniowuje pacjenta nawet do 400 razy większą dawką promieniowania niż typowa sesja diagnostyczna zwykłym aparatem rentgenowskim[3]. Tomografia komputerowa jest coraz popularniejszym badaniem i stale rośnie jej udział w sumarycznej dawce całej populacji ze wszystkich badań diagnostycznych. W Wielkiej Brytanii, w 1989, badania tomografami stanowiły 2% badań radiologicznych, dając 17% wkład w dawkę z badań promieniami rentgenowskimi. W 2001, liczby te wynosiły odpowiednio, 4% i 40%. Badania w USA wskazują nawet 70% udział tomografów w dawkach z badań medycznych[4][5].

Korzyści

Badanie za pomocą tomografu komputerowego jest bezbolesne i nieinwazyjne. Dostarcza bardzo szczegółowych informacji, które można przetworzyć cyfrowo na obrazy trójwymiarowe. Ma stosunkowo szybki i prosty przebieg, może więc uratować komuś życie, ponieważ pozwala wykryć obrażenia wewnętrzne. Tomografy komputerowe nie wpływają negatywnie na działanie wszczepionych aparatów medycznych.

Zobacz też

Przypisy

- 1 2 dr hab. Ryszard W. Gryglewski: Historia tomografii. Agencja Oceny Technologii Medycznych i taryfikacji. [dostęp 2024-02-29]. (pol.).

- 1 2 Joachim Pietzsch: The Nobel Prize in Physiology or Medicine 1979, Allan M. Cormack, Godfrey N. Hounsfield, Perspectives. [dostęp 2017-02-05].

- ↑ Informacje FDA o badaniach tomograficznych.

- ↑ Provision of MRI can significantly reduce CT collective dose.

- ↑ Radiation Dose from Adult and Pediatric Multidetector Computed Tomography.

Bibliografia

- Thomas S. Curry III, James Dowdey, Robert Murry Jr.: Christensen’s Physics of Diagnostic Radiology. Philadelphia: Lea & Febiger, 1990. ISBN 0-8121-1310-1.

![]() Przeczytaj ostrzeżenie dotyczące informacji medycznych i pokrewnych zamieszczonych w Wikipedii.

Przeczytaj ostrzeżenie dotyczące informacji medycznych i pokrewnych zamieszczonych w Wikipedii.