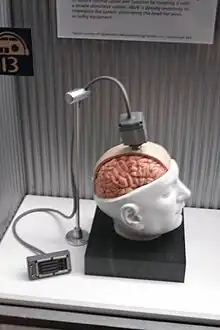

Interfejs mózg–komputer (ang. brain-computer interface, BCI) – interfejs pozwalający na bezpośrednią komunikację między mózgiem a odpowiednim urządzeniem zewnętrznym. Celem badań nad interfejsem mózg-komputer są usprawnienie lub naprawa ludzkich zmysłów albo czynności ruchowych. W komercyjnych celach technologia dostępna jest np. jako zamienniki joysticka lub klawiatury.

Historia

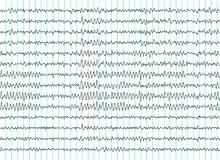

Historia interfejsów mózg-komputer rozpoczyna się od odkrycia przez Hansa Bergera aktywności elektrycznej w mózgu człowieka oraz rozwoju elektroencefalografii. W 1924 roku Berger był pierwszym, który zarejestrował aktywność ludzkiego mózgu za pomocą elektroencefalografu (EEG). Analizując wyniki EEG, Berger był w stanie zidentyfikować aktywność mózgu taką jak fale alfa (8–12 Hz) znane również jako fale Bergera.

Pierwsze urządzenie stworzone przez naukowca było niezwykle proste. Berger umieszczał srebrne przewody pod czaszkami pacjentów. Przewody te zostały później zastąpione przez srebrne folie umieszczone na czaszce pacjenta pod gumowymi bandażami. Te czujniki Berger łączył z elektrometrem Lippmanna, lecz jego badania nieodmiennie kończyły się niepowodzeniem. Bardziej wyrafinowane urządzenia, takie jak galwanometr Siemensa z podwójną cewką, który pokazywał napięcie elektryczne rzędu jednej tysięcznej volta, doprowadziły do sukcesu.

Berger analizował powiązania wyników z EEG jego mózgu z mózgami osób chorych psychicznie. EEG umożliwiło wytyczenie wielu nowych ścieżek w badaniach nad aktywnością ludzkiego mózgu i ogromnie przyczyniło się do rozwoju diagnostyki medycznej.

Badania na zwierzętach

Kilku laboratoriom udało się nagrać sygnał kory mózgowej małpy oraz szczura, aby za pomocą BCI pobudzić ruch. Małpy nawigowały kursorem na ekranie komputera oraz posługiwały się robotycznymi ramionami w zakresie prostych ruchów, po prostu myśląc o danej czynności i obserwując reakcje urządzenia[1]. W maju 2008 roku fotografie ilustrujące małpy z Centrum Medycznego Uniwersytetu w Pittsburghu poruszające ramionami robotów przy użyciu wyłącznie myśli zostały opublikowane w wielu znanych naukowych czasopismach i magazynach[2].

Początkowe badania

W 1969 roku badania nad warunkowaniem instrumentalnym Fetza oraz jego kolegów z Regionalnego Centrum Badań i Wydziału Fizjologii i Biofizyki na Waszyngtońskim Uniwersytecie Medycznym w Seattle pokazały po raz pierwszy, że małpy są w stanie opanować zginanie ramion robota wyposażonego w biologiczne sprzężenie zwrotne przy pomocy aktywności neuronalnej[3]. Podobna praca opublikowana w latach 70. ustaliła, że małpy potrafią w szybkim tempie nauczyć się rozmyślnie kontrolować aktywnością zarówno pojedynczych, jak i tych znajdujących się w grupach neuronów pierwotnej kory ruchowej, jeżeli były nagradzanie za generowanie odpowiednich wzorców aktywności neuronalnej[4].

Badania, których celem było opracowanie algorytmów służących do rekonstrukcji ruchów z neuronów kory ruchowej, datowane są na lata 70. W latach 80. Apostolos Georgopoulos, wywodzący się z Uniwersytetu Johnsa Hopkinsa, odkrył matematyczny związek między elektrycznymi sygnałami neuronów kory ruchowej małp makaków rezusów i kierunkiem ruchu ich ramion (bazując na funkcji cosinusa). Odkrył on również, że rozproszone grupy neuronów, w różnych obszarach mózgów małp, wspólnie kontrolowały polecenia ruchu. Niestety, z uwagi na panujące wówczas ograniczenia techniczne, był on w stanie rejestrować aktywność tylko jednego obszaru zapłonów neuronów jednocześnie[5].

W połowie lat 90. pojawił się, trwający do dziś, gwałtowny wzrost zainteresowania badaniami BCI[6]. Kilku zespołom udało się przechwycić skomplikowane sygnały kory ruchowej mózgu rejestrując stan zespołów neuronów i używając ich do kontroli urządzeń zewnętrznych. Ważniejsze grupy badawcze były prowadzone przez Richarda Andersena, Johna Donoghueego, Philipa Kennedy’ego, Miguela Nicolelisa i Andrew Swartza.

Kennedy i Yang Dan

Philip Kennedy (który odkrył sygnał neuronowy w 1987 roku) i jego koledzy stworzyli pierwszy dokorowy interfejs mózg-komputer poprzez wszczepienie neurotropowych stożków elektrod do mózgów małp. W 1999 roku badacze prowadzeni przez Yanga Dana z Uniwersytetu Kalifornii w Berkeley zdekodowali impulsy neuronowe, co umożliwiło im odtworzenie obrazów widzianych przez koty. Zespół użył siatki elektrod usytuowanych na wzgórzu ciała kolankowatego (które integruje wszystkie bodźce zmysłowe mózgu) kotów. Badacze nakierowali elektrody na 177 komórek mózgowych w obszarze wzgórza ciała kolankowatego bocznego, który dekoduje obrazy z siatkówki. Kotom pokazano osiem krótkich filmów, następnie nagrano impulsy neuronowe z ich mózgów. Korzystając z matematycznych filtrów, badacze zdekodowali sygnały, by utworzyć filmy z tego, co widziały koty i udało im się odtworzyć rozpoznawalne sceny i poruszające się obiekty[7]. Podobne sukcesy w badaniach nad ludźmi odnieśli później badacze z Japonii.

Nicolelis

.jpg.webp)

Miguel Nicolelis, profesor Uniwersytetu Duke’a w Durham w Karolinie Północnej, był orędownikiem korzystania z wielu elektrod rozmieszczonych na większym obszarze mózgu, w celu uzyskania sygnałów neuronowych do kierowania BCI. Takie zespoły neuronowe zwiększają precyzję i ułatwiają kontrolę interfejsu mózg-komputer. Po przeprowadzeniu wstępnych badań na szczurach w 1990 Nicolelis i jego koledzy opracowali BCI, które dekodowało aktywności mózgu małp sowich i używało zewnętrznego urządzenia do odtworzenia ruchów małp w ramionach robotów. Małpy mają zaawansowane umiejętności chwytania i sięgania i dobre umiejętności manipulacyjne rąk, co czyni je idealnymi obiektami badań do tego rodzaju pracy. W 2000 roku grupa zbudowała BCI, które odtwarzało ruchy małp sowich w czasie gdy te operowały joystickiem lub sięgały rękoma po jedzenie[8]. Interfejs ten działał w czasie rzeczywistym i mógł także przesyłać dane zdalnie do innego robota, korzystając z protokołu internetowego. Małpy jednak nie widziały robota ani nie otrzymywały żadnej odpowiedzi od interfejsu, nazwano więc go BCI z otwartą pętlą. Późniejsze eksperymenty Nicolelisa na małpach rezus zaowocowały w zamknięciu pętli BCI i pozwoliły odtworzyć ruchy małp na ramionach robotów. Małpy rezus uznawane są za lepsze obiekty do badań ze względu na ich budowę mózgu zbliżoną do ludzkiego. Małpy wstępnie operowały ramieniem używając joysticka i widząc obraz na ekranie komputera[9][10]. Później pokazano im robota bezpośrednio i nauczono kontrolować ramię poprzez obserwowanie jego ruchów. BCI wykorzystało prognozy prędkości z poprzedniego badania, by kontrolować zasięg uchwytu, a także siłę zacisku „dłoni”.

Donoghue, Schwartz i Andersen

Inne laboratoria, które zbudowały BCI zdolne odtworzyć sygnały neuronowe, prowadzone były między innymi przez Johna Donoghue z Uniwersytetu Browna, Andrew Swartza z Uniwersytetu Pittsburga oraz Richarda Andresena z Caltech. Badacze ci byli w stanie odtworzyć sygnały neuronowe z dużo mniejszej liczby neuronów niż Nicolelis (15-30 w porównaniu do 50-200 u Nicolelisa). Grupa Donoghue'a nauczyła małpy rezus, by te używały interfejsu mózg-komputer do śledzenia obiektów na ekranie komputera (zamknięta pętla) z oraz bez używania joysticka[11]. Grupa Schwartza stworzyło BCI pozwalające na śledzenie obiektów w przestrzeni trójwymiarowej i odtworzenie ruchów w ramieniu robota[12]. Udało im się dokonać przełomu, pokazując, że ich małpy potrafiły nakarmić się kawałkami owoców, używając ramienia robota sterowanego wyłącznie przez myśli tych małp.[13][14][15] Grupa Andersena używała nagrań ruchów wstępnych z tylnej kory ciemieniowej w ich BCI, w tym sygnałów mózgu zwierząt, które oczekiwały na nagrodę[16].

Neuralink

Eksperymenty w tym zakresie prowadzi również firma Neuralink, założona m.in. przez Elona Muska. Celem firmy jest stworzenie implantu, który pozwoliłby na obsługę komputerów i innych urządzeń elektronicznych za pomocą myśli. Wszczep łączyłyby z mózgiem elastyczne nici (o średnicy 4–6 mikrometrów) z elektrodami. 16 lipca 2019 Elon Musk poinformował, że Neuralink doprowadził do tego, iż małpa, dzięki specjalnemu wszczepowi, mózgiem obsługiwała komputer[17].

Inne badania

Oprócz przewidywania kinematycznych i kinetycznych parametrów ruchów kończyn rozwijane są interfejsy mózg-komputer do przewidywania elektromiograficznej lub elektrycznej aktywności mięśni naczelnych[18]. Takie BCI może być stosowane w celu przywrócenia mobilności w sparaliżowanych kończynach przez elektryczną stymulację mięśni. Miguel Nicolelis i współpracownicy wykazali, że aktywność dużych zespołów neuronalnych może przewidzieć pozycję ramienia. Praca ta umożliwiła stworzenie interfejsów BCI, które odczytują intencje ruchu ręki i przekładają je na ruchy sztucznych siłowników. Carmena i współpracownicy[9] zaprogramowali kodowanie neuronowe w BCI, które pozwoliło małpom kontrolować sięganie i chwytanie używając ramienia robota. Lebedev i inni[10] stwierdzili, że sieci mózgowe reorganizują się, aby utworzyć nową reprezentację robota, oprócz reprezentacji własnych zwierzęcych kończyn. Wykazali w ten sposób, że za obsługę robota odpowiada inna część mózgu niż ta operująca własnymi kończynami. Największą przeszkodą dla technologii BCI na początku drugiej dekady XXI wieku był brak modalności czujnika, który zapewniał bezpieczny, dokładny i solidny dostęp do sygnałów mózgowych. Można sobie wyobrazić, że takie czujniki zostaną opracowane w ciągu następnych kilkudziesięciu lat. Zastosowanie takiego czujnika powinno znacznie rozszerzyć zakres funkcji komunikacyjnych, które mogą być dostarczane za pomocą BCI. Opracowanie i wdrożenie systemu BCI jest skomplikowane i czasochłonne. W odpowiedzi na ten problem dr Gerwin Schalk rozwija ogólnego przeznaczenia system BCI do badań, zwany BCI2000. BCI2000 był opracowywany od 2000 roku w ramach projektu prowadzonego przez Brain-Computer Interface program R&D w Wadsworth Center w New York State Department of Health w Albany w stanie Nowy Jork, USA. Nowe „bezprzewodowe” podejście wykorzystuje światło-zależnych kanałów jonowych, takie jak Channelrhodopsin do kontrolowania aktywności genetycznej w określonych podgrupach neuronów in vivo. W ramach prostego zadania nauczania, oświetlenie transfekcji komórek kory czuciowej wpływa na proces podejmowania decyzji swobodnie poruszających się myszy[19]. W ramach projektu MINDWALKER podjęto również badania nad wykorzystaniem BCI do sterowania egzoszkieletem.

Nagroda BCI

Corocznie Nagroda BCI (fundowana przez g.tec), o wartości 3000 USD, przyznawana jest w uznaniu wybitnych i nowatorskich badań w dziedzinie interfejsu mózg-komputer. Każdego roku, znane laboratorium badawcze jest proszone o ocenę złożonych projektów i przyznania nagrody. Jury składa się z przodujących światowych ekspertów BCI rekrutowanych przez to laboratorium. Cuntai Guan, Kai Keng Ang, Karen Sui Geok Chua i Beng Ti Ang, z A * STAR w Singapurze, ze swoim projektem „Oparty na obrazach interfejs mózg-komputer sterujący robotem w pomocy nad rehabilitacją udarów”, zdobyli nagrodę BCI w 2010 roku. Moritz Grosse-Wentrup i Bernhard Schölkopf, z Max Planck Institute for Intelligent Systems w Niemczech, z ich projektem „Jakie są neurofizjologiczne przyczyny zmian wydajności w relacjach mózg-komputer?” zdobyli nagrodę BCI 2011. Nagroda BCI 2012 udała się do Surjo R. Soekadar i Niels Birbaumer (Applied Neurotechnology Lab, University Hospital Tübingen i Instytut Psychologii Medycznej i Behavioral Neurobiologia, Eberhard Karls University, Tübingen, Niemcy), w ramach projektu „Poprawa skuteczności stosowania Ipsilesionalnego interfejsu BCI w neurorehabilitacji przewlekłych udarów”.

Badania BCI na ludziach

Inwazyjne interfejsy

Wzrok

Inwazyjne badania BCI wykorzystywane były między innymi w naprawie uszkodzonego wzroku i zapewnienie nowej funkcjonalności dla osób z porażeniem wzroku. Inwazyjne interfejsy są wszczepiane bezpośrednio do istoty szarej mózgu przy użyciu metod neurochirurgii. Ponieważ leżą one w istocie szarej, inwazyjne urządzenia produkują sygnały najwyższej jakości, ale są podatne na gromadzenie się tkanki bliznowatej, co powoduje, że sygnał staje się słabszy, a nawet może zaniknąć całkowicie, jako że organizm reaguje na ciało obce w mózgu. W nauce o wzroku bezpośrednie implanty mózgowe były stosowane w leczeniu ślepoty nabytej. Jednym z pierwszych naukowców, którzy wyprodukowali działający interfejs BCI umiejący przywrócić wzrok był prywatny badacz William Dobelle. Pierwszy prototyp Dobelle'a został wszczepiony „Jerry'emu”, człowiekowi oślepionemu w wieku dorosłym, w 1978 roku. Jedno-siatkowe urządzenie BCI zawierający 68 elektrod wszczepiono na korę wzrokową Jerry’ego i udało się wygenerować fotyzm, uczucie widzenia światła. System zawierał kamery zamontowane na okulary do wysyłania sygnałów do implantu. Początkowo implant pozwolił Jerry'iemu zobaczyć odcienie szarości w ograniczonym polu widzenia w niskiej ilości klatek na sekundę. To wymagało, żeby Jerry był podłączony do głównego komputera, ale kurcząca się elektronika i szybsze komputery pozwoliły na stworzenie bardziej przenośnej wersji jego sztucznego oka i teraz umożliwiają mu wykonywanie prostych czynności bez pomocy osób trzecich[20].

W 2002 roku Jens Naumann, również oślepiony w dorosłym życiu, stał się pierwszym w serii 16 pacjentów, którzy otrzymali implanty Dobelle'a drugiej generacji, znakowanych jako jedne z pierwszych zastosowań komercyjnych interfejsów mózg-komputer. Urządzenie drugiej generacji stosowało bardziej wyrafinowany implant umożliwiający lepsze odwzorowanie fotyzmu w spójnej wizji. Fotyzmy były rozłożone w poprzek pola widzenia, co naukowcy nazywają „efektem gwieździstej nocy”. Natychmiast po otrzymaniu implantu, Jens był w stanie wykorzystać jego niedoskonale odtworzoną wizję, by kierować powoli samochodem wokół parkingu instytutu badawczego.

Ruch

Interfejsy mózg-komputer koncentrując się na neuroprotetyce ruchowej, dążą do przywrócenia ruchu u osób z porażeniem lub dostarczenia urządzenia, aby im pomóc w życiu codziennym, używając np. interfejsów z komputerów lub ramion robota. Naukowcy z Uniwersytetu Emory w Atlancie, na czele z Philipem Kennedym i Royem Bakayem, byli pierwszymi, którzy zainstalowali implant mózgu u człowieka, który to implant produkował sygnały o dobrej jakości, aby symulować ruch. Ich pacjent, Johnny Ray (1944-2002), cierpiał na zespół zamknięcia (Locked-in syndrome) po wystąpieniu udaru mózgu w jego pniu w 1997 roku. Implant Raya został zainstalowany w 1998 roku. Ray żył wystarczająco długo, aby rozpocząć pracę z implantem, w końcu nauczył się sterować kursorem komputera. Zmarł w 2002 roku z powodu tętniaka mózgu[21].

Sparaliżowany Matt Nagle stał się pierwszą osobą zdolną kontrolować sztuczną rękę za pomocą BCI w 2005 roku jako część pierwszego dziewięciomiesięcznego procesu testów ludzkiego układu implantów Cyberkinetics's BrainGate. Wszczepiony w prawą korę ruchową Nagle'a (obszar odpowiedzialny za ruch rąk), 96-elektrodowy implant BrainGate pozwolił Nagle'owi kontrolować ramię robota myśląc o ruchu ręką, a także kursor komputera, światła i telewizor[22]. Rok później, profesor Jonathan Wolpaw otrzymał nagrodę Fundacji Altran na rzecz innowacji za opracowanie interfejsu BCI z elektrod umieszczonych na powierzchni czaszki, a nie bezpośrednio w mózgu.

Ostatnio zespoły badawcze prowadzone przez grupy Braingate na Uniwersytecie Browna oraz grupa prowadzona przez Centrum Medyczne Uniwersytetu w Pittsburgu, we współpracy z Wydziałem Stanów Zjednoczonych do spraw Weteranów Wojennych, wykazały dalsze sukcesy w bezpośredniej kontroli zrobotyzowanych protez kończyn z wieloma stopniami swobody korzystając z bezpośrednich połączeń z neuronami kory ruchowej pacjentów z tetraplegią.

Częściowo inwazyjne BCI

Częściowo inwazyjne interfejsy mózg-komputer są wszczepiane w czaszkę, ale reszta zostaje na zewnątrz mózgu, a nie w istocie szarej. Wytwarzają one sygnały o wyższej rozdzielczości niż nieinwazyjne BCI, gdzie tkanki kostne czaszki odbijają i deformują sygnały oraz mają niższe ryzyko powstawania tkanki bliznowatej w mózgu niż interfejsy w pełni inwazyjne.

Elektrokortikografia (wewnątrzczaszkowe EEG – EcoG) mierzy aktywność elektryczną mózgu spod czaszki w podobny sposób do nieinwazyjnej elektroencefalografii, a elektrody są osadzone w cienkich wkładach z tworzywa sztucznego, które są umieszczone powyżej kory, pod oponą twardą[23]. Technologie ECoG najpierw wypróbowali u ludzi w 2004 roku Eric Leuthardt i Daniel Moran z Uniwersytetu Waszyngtońskiego w Saint Louis. W późniejszym badaniu naukowcy pozwolili nastolatkowi grać w Space Invaders używając swojego implantu EcoG[24]. To badanie wskazało, że kontrola jest gwałtowna, wymaga minimalnego przeszkolenia, oraz może być idealnym kompromisem w odniesieniu do wierności sygnału i poziomu inwazyjności (Uwaga: elektrody te nie zostały wszczepione pacjentowi z zamiarem opracowania BCI. Pacjent cierpiał na ciężką padaczkę, a elektrody zostały czasowo wszczepione, by pomóc jego lekarzom zlokalizować ogniska choroby; badacze BCI po prostu skorzystali z okazji do przeprowadzenia własnych badań). Sygnały mogą być podtwardówkowe lub zewnątrzoponowe, ale nie są wykonane w samym miąższu mózgu. Nie było to badane szeroko do niedawna ze względu na ograniczony dostęp do obiektów. Obecnie jedynym sposobem, aby uzyskać sygnał do badania, jest wykorzystanie pacjentów wymagających inwazyjnego monitorowania dla lokalizacji i usunięcia ogniska padaczkowego.

ECoG jest bardzo obiecującym pośrednim interfejsem BCI, ponieważ ma wyższą rozdzielczość przestrzenną, lepszy stosunek sygnału do szumu, szerszy zakres częstotliwości i mniejsze wymagania szkoleniowe niż nagranie EEG ze skóry głowy, a jednocześnie ma mniejsze trudności techniczne, niższe ryzyko kliniczne i prawdopodobnie lepszą długoterminową stabilność niż dokorową implementację do nagrywania jednego neuronu. Profil ten, wyposażony w najnowocześniejszy dowód wysokiego poziomu kontroli przy minimalnych wymogach kształcenia pokazuje potencjał prawdziwego zastosowania dla osób niepełnosprawnych ruchowo[25].

Urządzenia do obrazowania reakcji na światło są nadal w sferze teorii. To wiązałoby się z wszczepieniem lasera wewnątrz czaszki. Laser byłby szkolony na pojedynczym neuronie i odbiciach neuronu mierzonych oddzielnym czujnikiem. Gdy neuron wyzwoliłby impuls, wzór światła lasera i odbite fale zmieniłyby się nieznacznie. Pozwoliłoby to naukowcom na monitorowanie pojedynczych neuronów, lecz wymagałoby mniejszego kontaktu z tkanką i zmniejszyłoby ryzyko gromadzenia się tkanki bliznowatej.

Nieinwazyjne BCI

Oprócz inwazyjnych eksperymentów istniały również eksperymenty na ludziach z wykorzystaniem technologii nieinwazyjnego neuroobrazowania jako interfejsy BCI. Sygnały zapisane w ten sposób były wykorzystane do kontroli implantów mięśni i częściowego przywrócenia ruchu u ochotnika. Mimo że są one łatwe do noszenia, nieinwazyjne implanty produkują bardzo słaby sygnał, ponieważ czaszka tłumi, rozprasza i rozmywa fale elektromagnetyczne generowane przez neurony. Pomimo tego, że fale mogą nadal być wykrywane, trudniej jest określić obszar mózgu, który je wywołał lub też wyodrębnić działania pojedynczych neuronów.

EEG

Elektroencefalografia (EEG) jest najbardziej przebadanym potencjalnie nieinwazyjnym interfejsem, głównie ze względu na jego dobrą rozdzielczość uzyskiwaną w stosunkowo krótkim czasie, łatwość użytkowania, przenoszenia i niskie koszty instalacji. Niestety, jak również wrażliwość technologii na hałas, inną istotną barierą w korzystaniu z EEG jako interfejsu mózg-komputer jest intensywne szkolenie wymagane, by użytkownicy mogli pracować w tej technologii. Na przykład w eksperymentach rozpoczętych w połowie lat 1990, Niels Birbaumer na Uniwersytecie w Tybindze w Niemczech szkolił kilkanaście osób poważnie sparaliżowanych do samoregulacji powolnych korowych potencjałów ich EEG do tego stopnia, że sygnały te mogły być wykorzystane jako sygnał binarny do sterowania wskaźnikiem myszy[26]. (Birbaumer wcześniej szkolił epileptyków zapobiegać nadchodzącym atakom kontrolując tę małą falę napięcia). Eksperyment pokazał dziesięć pacjentów przeszkolonych do poruszania kursorem komputera przez kontrolowanie swoich fal mózgowych. Proces był powolny i wymagał więcej niż godzinę, by pacjenci zapisali 100 znaków za pomocą kursora, a szkolenia często trwały wiele miesięcy.

MEG i MRI

Magnetoencefalografia (MEG) i funkcjonalne obrazowanie rezonansem magnetycznym (fMRI), były razem z powodzeniem stosowane jako nieinwazyjne interfejsy mózg-komputer[27]. W szeroko omawianym eksperymencie fMRI pozwoliło na skanowanie dwóch użytkowników do gry Pong w czasie rzeczywistym, przez zmianę ich odpowiedzi hemodynamicznej i przepływu krwi przez mózg techniką biofeedbacku[28].

Pomiary fMRI hemodynamicznych odpowiedzi w czasie rzeczywistym zostały również wykorzystane do sterowania ramionami robota z siedmiosekundowym opóźnieniem między myślą i ruchem[29].

W 2008 badania opracowywane w Laboratorium Komputerowej Neurologii do Zaawansowanych Badań Telekomunikacyjnych (ATR) w Kyoto, w Japonii, pozwoliło naukowcom zrekonstruować obrazy bezpośrednio z mózgu i wyświetlać je na komputerze. Artykuł ogłaszający to osiągnięcie był tematem głównym w czasopiśmie Neuron z dnia 10 grudnia 2008 roku[30]. Podczas gdy wczesne wyniki są ograniczone do czarno-białych zdjęć na 10 × 10 kwadratów (pikseli), według naukowców dalszy rozwój technologii pozwoli osiągnąć kolorowe obrazy, a nawet nagrywać sny[31][32].

Neurogaming

Obecnie istnieje nowy obszar rozwoju gier nazywany neurogamingiem, który wykorzystuje nieinwazyjne BCI w celu poprawy wrażeń z gry, dzięki czemu użytkownicy mogą współdziałać z konsolą bez użycia tradycyjnego joysticka[33]. Niektóre programy neurogamingowe korzystają z fal mózgowych użytkownika, tętna, gestów, rozszerzeń źrenicy, a nawet emocji do wykonywania zadań lub wpływania na nastrój gry[34]. Na przykład, twórcy gry Emotiv stworzyli nieinwazyjne BCI, które określa nastrój gracza i dostosowuje muzykę lub dekoracje odpowiednio do emocji użytkownika. Obok neurogamingu, udoskonalenia w rękawicach do gier, takich jak rękawica Peregrine[35] tworzą nowe, bardziej efektywne formy gry użytkowników PC. Ta nowa forma interakcji pomiędzy użytkownikiem i oprogramowaniem pozwoli graczom na bardziej realistyczne wrażenia w grach[36]. Ponieważ będzie mniej połączeń między graczem a konsolą, Neurogaming pozwoli osobom wykorzystać swój „stan psychiczny”[37] i będzie mógł przenosić ich reakcje do gry w czasie rzeczywistym[36]. Neurogaming jest jeszcze w początkowej fazie rozwoju - pierwsza konferencja o Neurogaming odbyła się w San Francisco 1-2 maja 2013[38].

Cicha komunikacja („syntetyczna telepatia”)

Gerwin Schalk, w wynikach z badań z udzielonej na sumę 2,2 mln dolarów dotacji, stwierdził, że możliwe jest korzystanie z sygnałów EcoG do rozróżniania samogłosek i spółgłosek osadzonych w mowie i w wymyślonych słowach. Wyniki rzuciły światło na różne mechanizmy związane z produkcją samogłosek i spółgłosek, i mogły dostarczyć podstaw komunikacji za pomocą mózgu z użyciem wyobrażonego języka[39]. Badania nad syntetyczną telepatią z użyciem fonetyzacji miały miejsce na Uniwersytecie Kalifornijskim w Irvine pod dowództwem Mike’a D'Zmura. Pierwsza taka komunikacja odbyła się w 1960 roku przy użyciu EEG do tworzenia kodu Morse’a za pomocą fal alfa w mózgu. Korzystanie z EEG do komunikacji za pomocą wyobrażonej mowy jest jednak mniej dokładne niż inwazyjne metody wprowadzania elektrody między czaszkę a mózg.[40]

Komercjalizacja

John Donoghue i wpółbadacze założyli firmę Cyberkinetics. Firma, jako główny cel, postawiła na rozwój praktycznych interfejsów mózg-komputer dla ludzi. Firma sprzedaje swoje siatki elektrod pod nazwą BrainGate, które są oparte na macierzy Utah opracowanej przez Dicka Normanna.

Philip Kennedy założył Neural Signals w 1987 roku, by opracować BCI, które umożliwią sparaliżowanym pacjentom komunikować się ze światem zewnętrznym i sterować urządzeniami zewnętrznymi. Oprócz inwazyjnych BCI firma sprzedaje implant, który pozwala przywrócić mowę. „Brain Communicator” firmy Neural Signals wykorzystuje szklane stożki zawierające mikroelektrody pokryte białkami by te wiązały się z neuronami w mózgu.

Chociaż 16 pacjentów zostało uleczonych za pomocą wzrokowego BCI Williama Dobelle'a, nowe implanty przestały być produkowane w ciągu roku od śmierci Dobelle'a (zmarł w 2004 roku). Spółka kontrolowana przez Dobelle'a, Avery Biomedical Devices oraz Uniwersytet Stony'ego Brooka kontynuują rozwój implantu, lecz nie otrzymali jeszcze zatwierdzenia od Administracji do spraw Żywności i Używek dla ludzkiej implantacji w Stanach Zjednoczonych[41].

Ambient, na konferencji deweloperów IT na początku 2008 roku, pokazali produkt, który w czasie rozwoju nazwali The Audeo. Audeo celuje w stworzenie interfejsu mózg-komputer do komunikacji bez konieczności fizycznego sterowania silnikiem lub produkcji mowy. Korzystając z przetwarzania sygnału, niewymawiana mowa może być tłumaczona z przechwyconych sygnałów neurologicznych[42].

Midnball to produkt opracowany i skomercjalizowany przez szwedzką firmę Interactive Productline, w której gracze rywalizują o kontrolę ruchu piłki w całej planszy, poprzez stawanie się bardziej zrelaksowanym i skupionym[43]. Celem Interactive Productline jest rozwój i sprzedaż nieskomplikowanych produktów EEG, które trenują skupienie i relaksację[44].

Austriackie przedsiębiorstwo Guger Technologies lub g.tec[45], oferuje interfejs mózg-komputer już od 1999 roku. Firma zapewnia podstawowe modele BCI jako platformy rozwoju dla społeczności badawczej, takich jak P300 Speller, Motor Imagery oraz Steady-State Visual Evoked Potential. g.tec ostatnio opracowało g.SAHARA, które korzysta z suchych elektrod, mogących wytwarzać sygnały porównywalne do układów żelowych[46].

Hiszpańska firma Starlab, pojawiła się na rynku w 2009 roku razem z bezprzewodowym 4-kanałowym systemem o nazwie Enobio. W 2011 Enobio 8 i 20-kanałowe (CE Medical) zostało wydane i jest obecnie w handlu dzięki wyodrębnionej ze Starlab firmie Neuroelectrics. Zaprojektowany dla celów medycznych i naukowych system zapewnia rozwiązanie uniwersalne oraz platformę dla rozwoju aplikacji[47].

Istnieją trzy główne komercyjne urządzenia oraz komercyjni konkurenci w tej dziedzinie (data wprowadzenia na rynek w nawiasach), które uruchomiły takie urządzenia głównie do gier PC:

- Neural Impulse Actuator (kwiecień 2008 r.)

- Emotiv Systems (grudzień 2009)

- NeuroSky (MindSet – czerwiec 2009; Uncle Milton Force Trainer – jesień 2009, Mattel MindFlex lato 2009)

W roku 2009, pierwszy na świecie osobisty system translacji bazowany na EEG wszedł na rynek: IntendiX. System może pracować z pasywnymi, aktywnymi, lub nowymi suchymi elektrodami EEG. Pierwsza wersja używała P300 do pisania na matrycy o wyglądzie klawiatury. Oprócz pisania tekstu pacjent może korzystać z systemu do wyzwolenia alarmu, pozwalać komputerowi czytać tekst, wypisywać lub kopiować tekst do wiadomości e-mail lub wysyłać polecenia do urządzeń zewnętrznych. W marcu 2012 g.tec pokazał nowy moduł intendiX o nazwie Screen Overlay Control Interface (SOCI), który umożliwia użytkownikom grać w World of Warcraft lub Angry Birds.

Interfejs mózg-komputer u Stephena Hawkinga

Dr Stephen Hawking korzystał z interfejsu BCI, który pozwalał mu rozmawiać i prowadzić wykłady na uczelni. Za pomocą ruchu gałek ocznych Hawking był w stanie przekazać do generatora głosu swoje słowa. W 2011 roku na rynku pojawiła się nowa firma zajmująca się interfejsami BCI. Ich sztandarowy produkt, pałąk iBrain jest przenośnym, jednokanałowym urządzeniem EEG mającym na celu monitoring mózgu podczas snu. Pozwala zdiagnozować choroby takie jak bezsenność, depresja lub autyzm. Urządzenie zyskało sporą uwagę ze względu na to, że stało się częścią eksperymentu, który miał na celu umożliwienie dr Stephenowi Hawkingowi, choremu na stwardnienie zanikowe boczne (nazywane również ALS lub chorobą Lou Gehriga), komunikację za pomocą myśli. W 2012 roku Dr Philip Low, 32-letni prezes firmy NeuroVirgil o projekcie powiedział: „Chodzi o to, aby sprawdzić, czy Stephen może wykorzystać swój umysł do stworzenia spójnego i powtarzalnego wzoru, który komputer może przełożyć na, powiedzmy, słowa lub litery lub polecenie na komputerze[48]."

Interfejs mózg-komputer-mózg

Doświadczenie prowadzone w 2009 roku przez Christophera Jamesa z Uniwersytetu w Southampton pokazało, że wciąż można wymyślić coś nowego w dziedzinie BCI. Naukowcy postanowili pójść o krok dalej i spróbować porozumieć ze sobą dwa mózgi używając komputerów jako formę przesyłu myśli. Na razie udało się przesłać zaledwie 4 bity, lecz można to uznać za pewną formę komunikacji. Doświadczenie polegało na tym, że jeden ochotnik wyobrażał sobie kolejno jedną z dwóch liczb. Jeśli wybrał zero, miał w myślach „poruszyć” lewą ręką, jeśli jeden, prawą. Następnie interfejs odbierał sygnały z mózgu, dekodował je na formę cyfrową i Internetem przesyłał dane do drugiego ochotnika. Komputer przekazywał dane za pomocą szybkich błysków stroboskopu diodowego, których częstotliwość zależała od przekazanej liczby. Odbiorca patrzył na błyski, podczas gdy EEG rejestrowało fale mózgowe związane z aktywnością wzrokową. Co ważne, odbiorca nie mógł świadomie odróżnić błysków, gdyż dla niego były one takie same. Na podstawie odebranych sygnałów komputer bezbłędnie odkodował przesłaną wiadomość: 1011. Christopher James uważa, że interfejs ten mógłby się przydać ludziom z syndromem zamknięcia lub ze znacznymi ubytkami masy mięśniowej[49].

W 2013 roku człowiekowi udało się kontrolować ogon szczura poprzez interfejs mózg-komputer-mózg[50].

W 2014 roku za pomocą interfejsu mózg-komputer-mózg badacz poruszał ręką innego badacza[51].

W 2015 roku połączono ze sobą i z komputerem trzy mózgi rezusów, dzięki czemu wspólnie kontrolowały one mechaniczne ramię. Połączone mózgi osiągały lepszą sprawność niż pojedyncze małpy[52].

Również w tym roku połączenie czterech mózgów szczurów okazało się mądrzejsze niż niepołączone mózgi. Szczury wykonywały zadania z klasyfikacji obiektów, rozpoznawania obrazów, przechowywania i przetwarzania informacji ruchowych a także przewidywania pogody (zwiększona lub zmniejszona liczba impulsów dostarczana do mózgu reprezentowała informacje o ciśnieniu i temperaturze, na podstawie czego szczury prognozowały czy będzie padać deszcz)[53][54].

Względy etyczne

Ważne etyczne, prawne i społeczne problemy związane z relacjami mózg-komputer:[55][56][57][58]

- koncepcyjne zagadnienia (naukowcy nie zgadzają się na to, co jest, a co nie jest interfejsem BCI),

- uzyskanie świadomej zgody od osób, które mają trudności w komunikacji,

- stosunek ryzyka do korzyści,

- zbiorowa odpowiedzialność zespołów BCI (np. w jaki sposób zapewnić, że odpowiedzialne decyzje grupy mogą być wykonane),

- konsekwencje technologii BCI dla jakości życia chorych i ich rodzin,

- skutki uboczne (neurofeedback np. trening rytmu czuciowego wpływa na jakość snu),

- osobista odpowiedzialność i jej ewentualne ograniczenia (np. kto jest odpowiedzialny za błędne działania związane z neuroprotetyką),

- zagadnienia dotyczące osobowości i jej ewentualne zmiany,

- zastosowania terapeutyczne i ich możliwości przekroczenia,

- kwestie etyki badań, które powstają, gdy przechodzi się z doświadczeń na zwierzętach do zastosowania u ludzi,

- czytanie myśli i prywatność,

- kontrola umysłu,

- korzystanie z technologii w zaawansowanych technikach przesłuchań przez władze rządowe,

- selektywne wzmocnienie i rozwarstwienie społeczne,

- komunikacja z mediami.

Clausen stwierdził w 2009 roku, że „BCI stwarza etyczne wyzwania, ale te są koncepcyjnie podobne do tych, które bioetycy napotkali w innych domenach terapii”. Co więcej, sugeruje, że bioetyka jest dobrze przygotowana do radzenia sobie z problemami, które wynikają z technologii interfejsów mózg-komputer. Haselager i współpracownicy wskazali, że oczekiwania skuteczności BCI i wartości odgrywają wielką rolę w etycznej analizie i sposobie, w jaki naukowcy BCI powinni kontaktować się z mediami. Ponadto standardowe protokoły mogą być wdrożone w celu zapewnienia etycznie świadomego wydźwięku procedur z pacjentami z chorobą locked-in.

Badacze są świadomi tego, że etyczny wydźwięk, odpowiednio moderowany entuzjazm w mediach i edukacja na temat systemów BCI będą niezwykle ważne dla społecznej akceptacji tej technologii. Dlatego ostatnio coraz więcej starań jest czynionych wewnątrz wspólnoty BCI, by wykreować konsensus w sprawie etycznych wytycznych dla badań BCI, ich rozwoju i upowszechniania.

W 2012 roku naukowcy przy pomocy BCI opartego na EEG (fala P300) poznali z 10-40% dokładnością PIN-y do kart kredytowych, miejsce zamieszkania i datę urodzenia osób biorących udział w eksperymencie[59].

Tanie projekty BCI

Ostatnio wiele firm wykorzystało technologię EEG (oraz w jednym przypadku, NeuroSky, zbudowało technologicznie od podstaw) do tworzenia niedrogich interfejsów BCI. Technologia ta została wprowadzona do zabawek i urządzeń do gier, niektóre z tych zabawek odniosły komercyjny sukces jak NeuroSky i Mattel MindFlex.

- W 2006 roku Sony opatentował interfejs układu nerwowego pozwalający falom radiowym wpływać na sygnały w korze nerwowej[60].

- W 2007 Neurosky opublikował pierwsze niedrogie w produkcji konsumenckie EEG wraz z grą NeuroBoy. Było to również pierwsze urządzenie EEG na dużą skale korzystające z technologii suchych czujników[61].

- W 2008 OCZ Technology opracowało urządzenie do zastosowania w grach komputerowych opartych przede wszystkim na elektromiografii[62].

- W 2008 roku deweloper gry Final Fantasy, Square Enix, ogłosił, że współpracuje z NeuroSky by stworzyć grę Judecca[63][64].

- W 2009 Mattel współpracowało z NeuroSky, by wypuścić grę Mindflex, która używała EEG do kierowania piłką przez tor przeszkód. Zdecydowanie najlepiej sprzedawane konsumenckie EEG do 2012 roku.[Li, Shan (8 August 2010).reading is on the market”.[65]

- W 2009 roku Uncle Milton Industries podjęło współpracę z NeuroSky, by stworzyć Star Wars Force Trainer, gry mającej na celu stworzenie iluzji posiadania Mocy[63][66].

- W 2009 Emotiv Systems wydała EPoC, 14-kanałowe urządzenie EEG, które mogło odczytać 4 stany psychiczne, 13 świadomych stanów, mimikę i ruchy głowy. EPoC był pierwszym komercyjnym interfejsem mózg-komputer używającym techniki suchych czujników, które mogły być nasączone roztworem soli fizjologicznej dla lepszej przewodności[67].

- W listopadzie 2011 roku magazyn Time wybrał „Necomimi” wyprodukowane przez Neurowear jako jeden z najlepszych wynalazków lat. Firma ogłosiła, że oczekuje, aby uruchomić wersję konsumencką odzieży, na które składają się kocie uszy sterowane przez czytnik fal mózgowych produkowany przez NeuroSky, na wiosnę 2012 roku[68].

- W marcu 2012 g.tec przedstawił intendiX-Speller pierwszy komercyjnie dostępny system BCI do użytku domowego, który mógł być używany do kontrolowania gier komputerowych i aplikacji. Mógł wykryć różne sygnały w mózgu z dokładnością do 99%.[69] g.tec gościł kilka wycieczek warsztatowych, by pokazać system intendiX i inny sprzęt oraz oprogramowanie do wiadomości publicznej, takich jak Trasa Warsztatowa po Zachodnim Wybrzeżu USA z g.tec w okresie od września 2012 roku.

- W styczniu 2013 r. Narodowy Uniwersytet Hasaca (HNU) ogłosił pierwszy program Masters w oknie projektowania aplikacji w wirtualnej rzeczywistości interfejsu BCI.

Wybrane filmy zawierające interfejsy BCI

- Matrix, Trzynaste piętro - interfejsy rzeczywistości wirtualnej

- Iron Man – pancerz wspomagany reagujący na myśli pilota.

- Raport mniejszości – wyrocznie podłączone do komputera przekazywały wizje z ich umysłów na ekran.

- Chappie - sterowanie robotami za pomocą myśli

Przypisy

- ↑ Duke neurobiologist Miguel Nicolelis and colleagues report that they have developed a system that allows monkeys to control robot arms via brain signals. [dostęp 2016-04-30].

- ↑ Baum, Michele (6 września 2008). „Monkey Uses Brain Power to Feed Itself With Robotic Arm”. Pitt Chronicle. Odzyskano 2009-07-06

- ↑ Fetz, E. E. (1969). „Operant Conditioning of Cortical Unit Activity”. Science 163 (3870): 955–8

- ↑ Schmidt, EM; McIntosh, JS; Durelli, L; Bak, MJ (1978). „Fine control of operantly conditioned firing patterns of cortical neurons”. Experimental neurology 61 (2): 349–69

- ↑ Georgopoulos, A.; Lurito, J.; Petrides, M; Schwartz, A.; Massey, J. (1989). „Mental rotation of the neuronal population vector”. Science 243 (4888): 234–6

- ↑ Lebedev, MA; Nicolelis, MA (2006). „Brain-machine interfaces: past, present and future”. Trends in neurosciences 29 (9): 536–46

- ↑ Stanley, GB; Li, FF; Dan, Y (1999). „Reconstruction of natural scenes from ensemble responses in the lateral geniculate nucleus”. Journal of Neuroscience 19 (18): 8036–42

- ↑ Nicolelis, Miguel A. L.; Wessberg, Johan; Stambaugh, Christopher R.; Kralik, Jerald D.; Beck, Pamela D.; Laubach, Mark; Chapin, John K.; Kim, Jung et al. (2000). „Real-time prediction of hand trajectory by ensembles of cortical neurons in primates”. Nature 408(6810): 361–5

- 1 2 Carmena, JM; Lebedev, MA; Crist, RE; O’Doherty, JE; Santucci, DM; Dimitrov, DF; Patil, PG; Henriquez, CS et al. (2003). to control a brain-machine interface for reaching and grasping by primates”. PLoS Biology 1 (2): E42

- 1 2 Lebedev, M. A.; Carmena, JM; O’Doherty, JE; Zacksenhouse, M; Henriquez, CS; Principe, JC; Nicolelis, MA (2005). „Cortical Ensemble Adaptation to Represent Velocity of an Artificial Actuator Controlled by a Brain-Machine Interface”. Journal of Neuroscience 25 (19): 4681–93

- ↑ Serruya, MD; Hatsopoulos, NG; Paninski, L; Fellows, MR; Donoghue, JP (2002). „Instant neural control of a movement signal”. Nature 416 (6877): 141–2

- ↑ Taylor, D. M.; Tillery, SI; Schwartz, AB (2002). „Direct Cortical Control of 3D Neuroprosthetic Devices”. Science 296 (5574): 1829–32

- ↑ Pitt team to build on brain-controlled arm. pittsburghlive.com:8000. [zarchiwizowane z tego adresu (2007-07-04)]., Pittsburgh Tribune Review, 5 September 2006

- ↑ YouTube – Monkey controls a robotic arm. Youtube.com. Retrieved on 2012-05-29

- ↑ Velliste, M; Perel, S; Spalding, MC; Whitford, AS; Schwartz, AB (2008). „Cortical control of a prosthetic arm for self-feeding”. Nature 453 (7198): 1098–101

- ↑ Musallam, S.; Corneil, BD; Greger, B; Scherberger, H; Andersen, RA (2004). „Cognitive Control Signals for Neural Prosthetics”. Science 305 (5681): 258–62

- ↑ Firma Elona Muska sprawiła, że małpa obsługiwała komputer mózgiem. Business Insider Polska, 2019-07-17. [dostęp 2019-07-18].

- ↑ Santucci, David M.; Kralik, Jerald D.; Lebedev, Mikhail A.; Nicolelis, Miguel A. L. (2005). „Frontal and parietal cortical ensembles predict single-trial muscle activity during reaching movements in primates”. European Journal of Neuroscience 22 (6): 1529–40

- ↑ Huber, D; Petreanu, L; Ghitani, N; Ranade, S; Hromádka, T; Mainen, Z; Svoboda, K (2008). optical microstimulation in barrel cortex drives learned behaviour in freely moving mice”. Nature 451 (7174): 61–4

- ↑ Vision quest, Wired Magazine, September 2002

- ↑ Kennedy, PR; Bakay, RA (1998). „Restoration of neural output from a paralyzed patient by a direct brain connection”. NeuroReport 9 (8): 1707–11

- ↑ Leigh R. Hochberg; Mijail D. Serruya, Gerhard M. Friehs, Jon A. Mukand, Maryam Saleh, Abraham H. Caplan, Almut Branner, David Chen, Richard D. Penn and John P. Donoghue (13 July 2006). „Neuronal ensemble control of prosthetic devices by a human with tetraplegia”. Nature 442 (7099): 164–171

- ↑ Serruya MD, Donoghue JP. (2003) Chapter III: Design Principles of a Neuromotor Prosthetic Device in Neuroprosthetics: Theory and Practice, ed. Kenneth W. Horch, Gurpreet S. Dhillon. Imperial College Press

- ↑ Teenager moves video icons just by imagination, press release, Washington University in St Louis, 9 October 2006

- ↑ X, Pei (2011). Vowels and Consonants in Spoken and Imagined Words Using Electrocorticographic Signals in Humans”. J Neural Eng 046028th ser. 8.4. Retrieved 12 February 2012

- ↑ short of telepathy: can you interact with the outside world if you can't even blink an eye?, Psychology Today, May–June 2003

- ↑ Ranganatha Sitaram, Andrea Caria, Ralf Veit, Tilman Gaber, Giuseppina Rota, Andrea Kuebler and Niels Birbaumer(2007) Brain–Computer Interface: A Tool for Neuroscientific Research and Treatment”

- ↑ Mental ping-pong could aid paraplegics, Nature, 27 August 2004

- ↑ operate robot only with brain, ATR and Honda develop BMI base technology,Tech-on, 26 May 2006

- ↑ Miyawaki, Y; Uchida, H; Yamashita, O; Sato, MA; Morito, Y; Tanabe, HC; Sadato, N; Kamitani, Y (2008). „Decoding the Mind's Eye – Visual Image Reconstruction from Human Brain Activity using a Combination of Multiscale Local Image Decoders”. Neuron 60 (5): 915–929

- ↑ extract images directly from brain”. PinkTentacle.com. 12 December 2008

- ↑ „あなたの夢、映像化できるかも!?”. chunichi.co.jp. [zarchiwizowane z tego adresu (2008-12-12)].. Chunichi Web. 11 December 2008. (Japanese)

- ↑ Emotiv on Discovery Channel - Next World [online], www.youtube.com [dostęp 2017-11-24] (fr.).

- ↑ Let the NeuroGames Begin | GamesBeat [online], venturebeat.com [dostęp 2017-11-24] (ang.).

- ↑ A Gaming Glove That's Fast Enough for Pros [online], www.youtube.com [dostęp 2017-11-24] (fr.).

- 1 2 EmotivOverview.mov [online], www.youtube.com [dostęp 2017-11-24] (fr.).

- ↑ NeuroGaming: Merging Cognitive Neuroscience & Virtual Simulation in an Interactive Training Platform. - Advanced Brain Monitoring [online], advancedbrainmonitoring.com [dostęp 2017-11-24] (ang.).

- ↑ Neurogamingconf.Com [online], www.neurogamingconf.com [dostęp 2017-11-24].

- ↑ Kennedy, Pagan (18 September 2011). Cyborg in Us All”. . Retrieved 28 January 2012

- ↑ Army developing ‘synthetic telepathy’ - Technology & science - Science - DiscoveryNews.com | NBC News [online], www.nbcnews.com [dostęp 2017-11-24] (ang.).

- ↑ Press release, Stony Brook University Center for Biotechnology, 1 maja 2006 [zarchiwizowane z adresu 2006-09-10].

- ↑ Your Mind. Theaudeo.com. Retrieved on 2012-05-29

- ↑ Welcome to Mind Ball. vivifeye.com. [zarchiwizowane z tego adresu (2010-04-03)].. Vivifeye.com (8 March 2012). Retrieved on 2012-05-29

- ↑ Interactive Productline About us. mindball.se. [zarchiwizowane z tego adresu (2012-12-05)].. Mindball.se. Retrieved on 2012-05-29

- ↑ Technologies”

- ↑ Guger et al., 2012, Frontiers in Neuroscience

- ↑ http://neuroelectrics.com/enobio%7C„ENOBIO”

- ↑ Eksperyment nad nowym interfejsem BCI do rozmowy za pomocą myśli. [dostęp 2013-06-10]. [zarchiwizowane z tego adresu (2013-06-14)].

- ↑ Interfejs mózg-internet-mózg

- ↑ Non-Invasive Brain-to-Brain Interface (BBI): Establishing Functional Links between Two Brains [online], journals.plos.org [dostęp 2017-11-24] (ang.).

- ↑ A Direct Brain-to-Brain Interface in Humans [online], journals.plos.org [dostęp 2017-11-24] (ang.).

- ↑ Computing Arm Movements with a Monkey Brainet.

- ↑ Building an organic computing device with multiple interconnected brains.

- ↑ Rats ‘brain net’ tests recreate Hollywood collective intelligence.

- ↑ Clausen, Jens (2009). „Man, machine and in between”. Nature 457 (7233): 1080

- ↑ Haselager, Pim; Vlek, Rutger; Hill, Jeremy; Nijboer, Femke (2009). „A note on ethical aspects of BCI”. Neural Networks 22 (9): 1352

- ↑ Tamburrini, Guglielmo (2009). „Brain to Computer Communication: Ethical Perspectives on Interaction Models”. Neuroethics 2 (3): 137

- ↑ Nijboer, Femke; Clausen, Jens; Allison, Brendan Z; Haselager, Pim (2011). „Stakeholders' opinions on ethical issues related to brain-computer interfacing”. Neuroethics

- ↑ » Zhackowali ludzki mózg i odczytali PIN-y do kart kredytowych - Niebezpiecznik.pl [online], niebezpiecznik.pl [dostęp 2017-11-24].

- ↑ patent neural interface”

- ↑ Games”. The Economist. 23 March 2007

- ↑ „Game Controller Product Page”. OCZ Technology Group. Retrieved 2013-01-30

- 1 2 Li, Shan (8 August 2010). reading is on the market”.

- ↑ with NeuroSky and Square Enix's Judecca mind-control game. Engadget.com (9 October 2008). Retrieved on 2012-05-29

- ↑ New games powered by brain waves. physorg.com. [zarchiwizowane z tego adresu (2011-11-08)].. Physorg.com. Retrieved on 2010-09-12

- ↑ Snider, Mike (7 January 2009).„Toy trains 'Star Wars' fans to use The Force”. USA Today. Retrieved 2010-05-01

- ↑ Systems Homepage”. Emotiv.com. Retrieved 2009-12-29

- ↑ selected „TIME MAGAZINE / The 50 best invention of the year”. Neurowear.com. Retrieved on 2012-05-29

- ↑ „"intendiX-SOCI”: g.tec Introduces Mind-controlled Computer Gaming at CeBIT2012". . 5 March 2012

Linki zewnętrzne

- toiowonaukowo.blogspot.com strona dotycząca tematyki BCI

- bci2000.org oprogramowanie do systemów BCI, udostępniane z kodem źródłowym przez Wadsworth Center z Nowego Jorku na licencji typu 'non-disclosure'

- Open BCI Project. bci.fuw.edu.pl. [zarchiwizowane z tego adresu (2009-04-20)].

- 403 - Forbidden. braincomputerinterface.com. [zarchiwizowane z tego adresu (2013-09-08)]. Strona z aktualnościami z dziedziny BCI

- http://www.fais.uj.edu.pl/wydzial/video-fotoreportaze/-/journal_content/56_INSTANCE_Df4E/41628/9116736 Rodzimy projekt BCI z Uniwersytetu Jagiellońskiego